in de vorige post eindigde ik met het eerste proefshot waarbij zowel de dolly als de camera motorisch in beweging waren terwijl de camera stopframe een serie foto’s nam. in deze post laat ik zien wat ik van plan ben er daarna mee te gaan doen en of dat allemaal werkt.

om te beginnen: zoals je uit de verhalen over motortjes die van alles aandrijven kan afleiden, is het de bedoeling dat de camera vrijwel in elk shot in beweging is. dat houdt in dat steeds als we een miniatuur-set willen uitbreiden in de computer, het noodzakelijk is om dat shot om te zetten naar een zo precies mogelijke versie in 3D. als eerste stap gebruik ik daarvoor syntheyes, een programma waarmee je het pad van de camera uit live action footage kan uitrekenen.

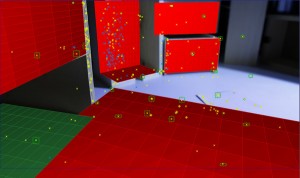

hoewel de beelden die we schieten een erg kleine scherptediepte hebben (een gevolg van de kleine schaal; het is bijna macro-fotografie) en dat weinig houvast geeft bij het tracken, lukt het goed om het pad van de camera precies te reconstrueren.

om te controleren of de 3D-camera hetzelfde doet als de echte, zet ik 3D-voorwerpen op de plek waar in het shot echte voorwerpen staan en kijk of alles exact mee beweegt.

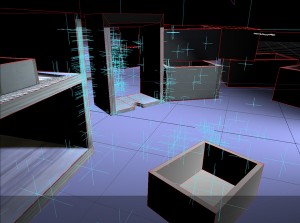

op basis van de footage kan het programma daarna heel precies de textuur van die voorwerpen reconstrueren – ook al fotografeer je in geen enkel frame een voorwerp in z’n geheel, het programma kijkt naar alle frames bij elkaar en bouwt daaruit het beeld van zo’n voorwerp op. hier heb ik dat gedaan met een paar van de kistjes uit het shot.

daar kan ik dan in mijn 3D-animatiepakket (in dit geval LightWave3D) een volledig 3D-model van de set mee bouwen.

dat is dan eigenlijk een virtuele versie van het miniatuurshot. met virtuele lichten op de juiste plek en de juiste instellingen voor de lens kan ik dan in de computer vrij exact hetzelfde beeld maken als wat we eerder hebben gefotografeerd. alleen is het verschil dat nu allerlei onderdelen in het shot kunnen worden toegevoegd en dat die precies zullen meebewegen en precies hetzelfde zullen reageren op het licht en de lensinstellingen als het echte materiaal.

in het voorbeeld heb ik een aantal houten kistjes toegevoegd aan het shot, de rode trackingstickertjes en het stukje papier dat op de grond lag eruit gehaald, de grote plank die op de voorgrond lag eruit gehaald en de camera aan het eind van het shot door laten bewegen, door het kistje heen (waar ik de bodem uit weg heb gehaald) en weer een aantal nieuwe kistjes daarachter gezet. plus de belichting zo aangepast dat je nog wat ziet aan het eind van het shot, in het origineel was het daar een donker gat.

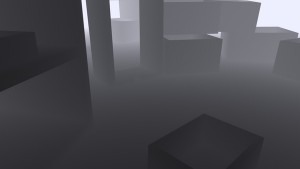

een laatste ding dat ik nog wilde uitproberen was het maken van een ‘depthpass’, een beeld waarin voorwerpen witter of zwarter worden naarmate ze dichter bij of verder van de camera af staan. en dan zien of ik daarmee bij het compositen de korte macro-scherptediepte van de originele beelden goed genoeg kan imiteren. het voordeel daarvan is dat ik achteraf de focus op een andere plek kan leggen dan in het gefotografeerde materiaal.

hier het resultaat: eerst het originele materiaal (wat gefotografeerd is met de camera dus), dan het bewerkte shot met alle weggehaalde en toegevoegde voorwerpen en daarna nog een splitscreen met een wireframe en de depthpass.